爬虫技术

用phpSpider爬虫采集糗事百科(改进版)

接着上一篇《用phpSpider爬虫采集糗事百科》程序的改进版,测试时发现phpSpider在单次执行任务的时候自带URL过滤重复,但是如果重复执行的时候程序会重复抓取,所以我们需要建立一个url的字段来保存历史抓取记录,每次入库前如果判断一下该URL是否抓取过了即可。

用phpSpider爬虫采集糗事百科

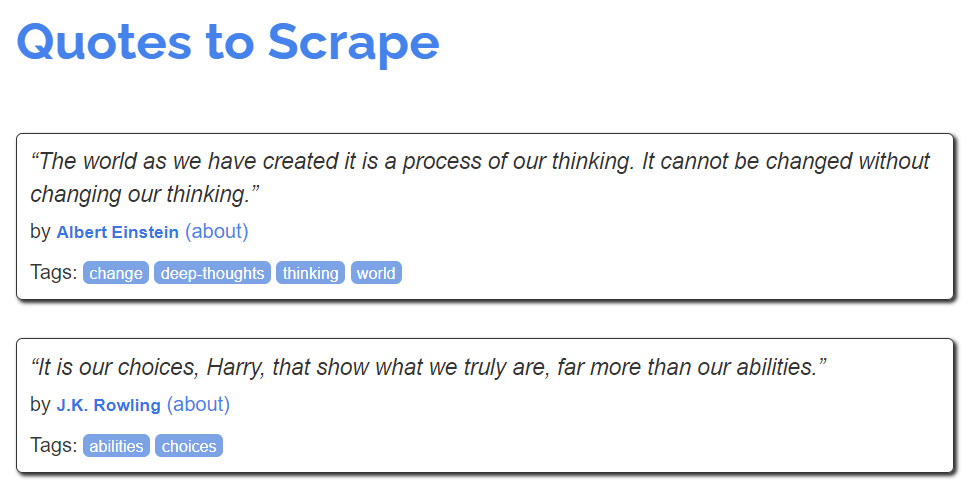

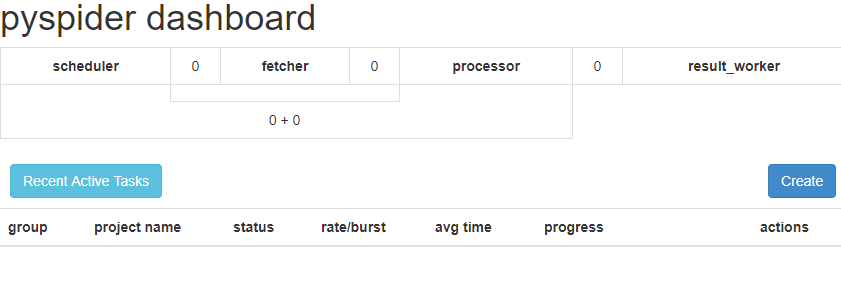

今天发现了一个好玩的php爬虫框架phpSpider,这里写了个官方的demo,可以采集糗百的内容和作者。

让CURL和Guzzle跟踪301跳转的重定向链接

php中使用curl或者guzzle爬虫框架对301重定向链接的两种处理方法